Performances

Niveau Sonore

Système de refroidissement

Design

Prix

Il n'y a pas grand chose à reprocher à l'Asus ROG Strix RTX 2080 ti, à part le prix bien sûr mais c'est inhérent à ces modèles. La qualité de fabrication ainsi que les finitions sont excellentes, l'ajout d'une petite plaque métallique pour assurer la rigidité de l'ensemble est un petit plus sympathique. L'énorme système de refroidissement est encore une fois un modèle du genre, permettant à la fois d'avoir d'excellentes performances mais également un silence de fonctionnement très appréciable (si vous mettez le BIOS en mode silencieux bien entendu).

[Test] Asus ROG Strix RTX 2080 Ti

Bonjour à tous!

Les nouvelles RTX de chez Nvidia sont sorties il y a quelques jours, n’ayant eu notre exemplaire de test que très tard à la rédaction, il fut plus sage de retarder le test pour ne pas bâcler la chose. Nous allons donc vous proposer aujourd’hui le test de la toute dernière carte Asus équipée du GPU Nvidia RTX 2080 Ti, la ROG Strix en versions OC (la plus performante de la gamme)!

Les RTX marquent un changement majeur chez Nvidia, avec une architecture qui est destinée a tirer partie des prochaines technologies, comme le Real time ray tracing et le DLSS qui ne sont pas prises en charge au niveau hardware par les GTX actuelles. Nous allons donc vous présenter ce que sont ces nouvelles technologies, en plus bien sûr des benchmarks de coutume et de la carte Asus elle-même!

Présentation

Architecture Turing

Nvidia nous propose ses nouveaux GPUs en les présentant comme étant le plus gros pas en avant de tous les modèles « depuis plus de 10 ans ». Avant même de commencer il est bon de noter que Turing est décliné en 3 GPU pour le moment, les TU102, TU104 et TU106. La RTX 2080 Ti utilise le TU102, mais qui est cependant une version un peu « castrée ». Le TU102 dispose au maximum de 72 coeurs RT, de 4608 coeurs CUDA, 576 coeur Tensor et de 12 Go de mémoire, la 2080 Ti quant à elle en a respectivement 68, 4352, 544 et 11 Go, de quoi voir une Titan arriver d’ici peu? 😉

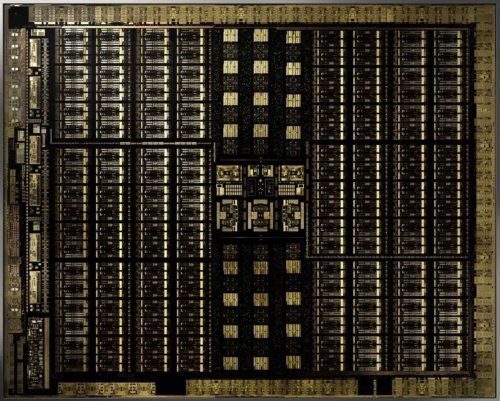

Le GPU utilisé pour la 2080 Ti utilise pas moins de 18.9 milliards de transistors, ce qui en fait une puce extrêmement grosse, même si elle est gravée en 12nm. Certains parlent même d’une prouesse d’en faire tenir autant dans le même DIE.

L’architecture Turing dispose d’un nouveau design reprenant en grande partie ce qui a été introduit avec les Volta GV100 (GPU dédiés aux calculs), avec pour chaque TPC (Texture / Processeur cluster) deux SM (Streaming Multiprocessor), chaque SM ayant un total de 64 coeurs FP32 / INT32. A titre de comparaison les GPU Pascal GP10x n’ont qu’un seul SM par TPC.

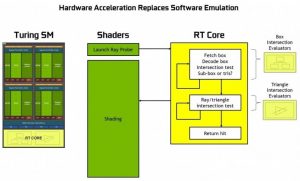

Chaque SM est doté de huit coeurs Tensor (utilisés pour le « Deep Learning ») et un coeur RT (Ray Tracing), ces derniers étant eux qui vont gérer tout ce qui est DLSS et Real time ray tracing, les avancés majeures en terme de rendus visuels.

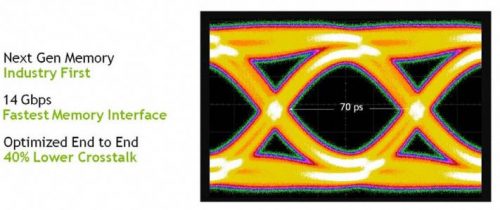

Les nouvelles RTX utilisent également de la mémoire GDDR6, permettant un débit largement supérieur par rapport à ce que l’on trouvait sur la GDDR5X, passant de 11 Gbps pour les anciennes GTX 1080 Ti à 14 Gbps pour la nouvelle RTX 2080 Ti, ce qui n’est pas négligeable. En plus de cela la consommation est également revue à la baisse, ce qui n’est pas plus mal même si la mémoire n’est pas l’élément consommant le plus sur une carte graphique.

Deep Learning Super-Sampling (DLSS)

Les coeurs Tensor sont des unités de calcul spécialisée dans les calculs matriciels, qui sont les fonctions de calculs de base utilises dans le Deep Learning. Ils sont utilisés pour le calcul du DLSS (Deap Learning Super Sampling). Le DLSS exploite un réseau neuronal profond pour extraire les caractéristiques de la scène rendue et combiner intelligemment les détails de plusieurs images pour construire une image finale de haute qualité.Cela permet aux GPU Turing d’utiliser la moitié des échantillons pour le rendu et d’utiliser l’intelligence artificielle pour compléter les informations afin de créer l’image finale. Le résultat est une image claire et nette avec une qualité similaire à celle du rendu traditionnel (qui repose généralement sur le Temporal AA (TAA) dans la plupart des derniers jeux actuels), mais avec des performances supérieures.

Pour chaque jeu, un entrainement est nécessaire sur les supercalculateurs de NVIDIA pour développer le réseau neuronal. Une fois celui-ci entrainé, l’inférence (nom du réseau neuronal entrainé) est distribuée au joueur via GeForce Experience ou dans le futur via les drivers. Les cœurs Tensor de la carte graphique exploitent alors ce réseau neuronal pour rendre des images détaillées, tout en offrant des performances supérieures au TAA. Comme le DLSS utilisent les cœurs Tensor et non plus les cœurs CUDA pour le TAA, le nombre de FPS affiché est supérieur à l’ancienne méthode tout en affichant une qualite visuelle supérieure, ce qui est un plus! A titre de comparaison le DLSS équivaut à un jeu tournant avec un supersampling 32X, vous pouvez tout de suite oublier avec un GPU « classique ».

Comme vous pouvez le voir ci-dessus tous les petits détails sont bien plus nets avec le DLSS d’activé, sans perte de performances. Pour le moment nous avons 25 jeux annoncés pour être compatibles avec le DLSS, ce qui est un bon début mais il faut espérer que ce nombre augmente drastiquement, sinon il sera difficile de justifier le changement de carte 😉 A noter que Nvidia propose gratuitement aux développeurs toute la partie calculs sur leurs serveurs, ce qui est toujours bon à savoir.

Real-time Ray Tracing

NVIDIA GeForce RTX 2080 Ti sur Battlefield V en vidéo, avec du Real-Time Ray Tracing!

Le Real time ray tracing est le gros du pavé et ce pour quoi on trouve tant d’ébats sur les forums partout dans le monde. Il a pour but de rendre les effets de lumière les plus réalistes possibles dans les scènes, au lieu de jouer d’artifices pour créer des réflexions et autres.

Par le passé le ray tracing était déjà utilisé, mais pour rendre des scènes pré-calculées, ou mêmes des images, il n’a jamais été possible de faire tourner un jeu avec le ray tracing en temps réel.

Jusqu’à présent les jeux utilisaient une technique de rastérisation (cf wikipédia) pour afficher les effets de lumières. Même si le rendu peut être très bon, il impose certaines limitations et des artefacts peuvent apparaitre en plus de l’aliasing, ce qui n’est pas idéal et pas forcément réaliste.

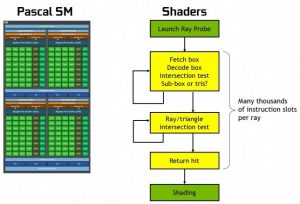

Nvidia a commencé à travailler sur le Ray tracing à l’époque des Gefore 8800, autant dire que cela date quand même un peu (10 ans!). Pour permettre le Ray tracing en temps réel, il faut avoir une puissance de calcul bien supérieure à ce que n’importe quelle carte graphique est capable de faire de nos jours. La firme a donc opté pour une approche « hybride », en faisant un mélange de rastérisation et de ray tracing, utilisant le premier lorsqu’il n’est pas nécessaire d’utiliser le deuxième. Le ray tracing sera donc utilisé pour les réflexions, réfractions ou encore les ombres. Cela permet de combiner le meilleur des deux mondes, et d’être moins « gourmand ».

Les cartes basées sur l’architecture Turing sont donc équipées de coeurs RT, un par Sreaming Multiprocessor pour un total de 72. Les coeurs RT sont là pour gérer tout ce qui touche au ray tracing, que cela soit via les librairies Nvidia, Nvidia OptiX, l’API Microsoft DirectX Raytracing ou même l’API Vulkan. Il faut bien comprendre donc que le ray tracing n’est pas quelque chose uniquement réservé aux cartes Nvidia, si demain AMD nous propose une nouvelle carte graphique, elle pourra tout à fait exploiter cette technologie.

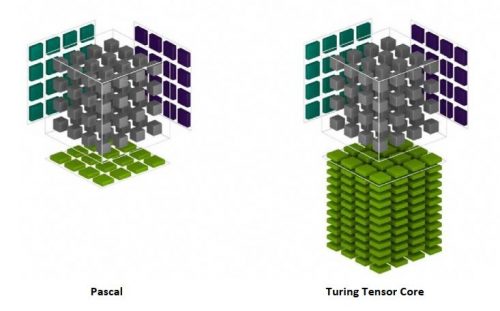

Sans coeurs RT le rendu utilisant le ray tracing devrait être fait par voie logicielle, et autant dire que vous pouvez tout de suite oublier si vous espérer un jeu qui ressemble à autre chose qu’un diaporama 😉 Comme vous pouvez le voir juste au dessus, lorsque l’architecture Pascal devait faire du ray tracing, tout les calculs se faisaient en software. Turing quant à lui fait sa propre tambouille en hardware via ses coeurs RT, les performances n’ont bien entendu rien à voir. A titre de comparaison, une RTX 2080 Ti est grosso modo dix fois plus performante dans ces tâches que « l’ancienne » GTX 1080 Ti.